- Forfatter Lynn Donovan [email protected].

- Public 2023-12-15 23:51.

- Sist endret 2025-01-22 17:36.

De treningsfeil vil vanligvis være mindre enn de testfeil fordi de samme dataene som brukes for å passe modellen brukes til å vurdere dens treningsfeil . En del av avviket mellom treningsfeil og testfeil er fordi opplæring sett og test sett har forskjellige inngangsverdier.

Følgelig, er valideringsfeilen alltid høyere enn treningsfeilen?

Men generelt sett, treningsfeil vil nesten bestandig undervurder din valideringsfeil . Det er imidlertid mulig for valideringsfeil å være mindre enn treningen . Du kan tenke på det på to måter: Din opplæring sett hadde mange "vanskelige" saker å lære.

Dessuten, hvorfor øker treningsfeilen? Imidlertid feil på testsettet reduseres bare ettersom vi legger til fleksibilitet opp til et visst punkt. I dette tilfellet skjer det ved 5 grader som fleksibilitet øker utover dette punktet treningsfeil øker fordi modellen har memorert opplæring data og støy.

På samme måte kan du spørre, hva er treningsfeil og testfeil?

Treningsfeil oppstå når a trent modellen returnerer feil etter å ha kjørt den på dataene igjen. Det begynner å returnere feil resultater. Test feil er de som skjer når en trent modellen kjøres på et datasett som den ikke har noen formening om. Det betyr at opplæring data er helt annerledes enn testing data.

Hvorfor er valideringsnøyaktigheten høyere enn treningsnøyaktigheten?

De opplæring tap er høyere fordi du har gjort det kunstig vanskeligere for nettverket å gi de riktige svarene. Imidlertid under validering alle enhetene er tilgjengelige, så nettverket har sin fulle beregningskraft - og dermed kan det yte bedre enn i opplæring.

Anbefalt:

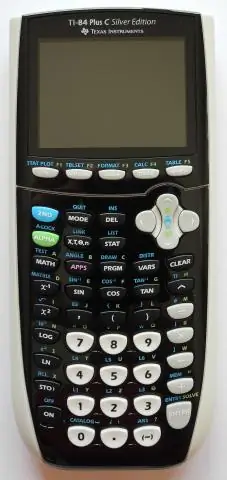

Hvordan får du mindre enn tegn på TI 84?

Ti-84 Plus Graphing Calculator For Dummies, 2nd Edition Bruk piltastene til å plassere markøren på tegnet til funksjonen eller ulikheten du definerer. Trykk på [ALPHA] og trykk på tasten under det aktuelle likhets- eller ulikhetssymbolet. For å få det første skjermbildet, trykk [ALPHA][ZOOM] for å angi et mindre enn eller likhetstegn

Hvorfor er symmetrisk kryptering raskere enn asymmetrisk kryptering?

For standard krypterings-/dekrypteringsfunksjoner fungerer symmetriske algoritmer generelt mye raskere enn deres asymmetriske motparter. Dette skyldes det faktum at asymmetrisk kryptografi er massivt ineffektiv. Symmetrisk kryptografi er designet nøyaktig for effektiv behandling av store datamengder

Hvorfor er en flat database mindre effektiv enn en relasjonsdatabase?

En enkelt flatfiltabell er nyttig for å registrere en begrenset mengde data. Men en stor flat-fil-database kan være ineffektiv da den tar opp mer plass og minne enn en relasjonsdatabase. Det krever også at nye data legges til hver gang du legger inn en ny post, mens en relasjonsdatabase ikke gjør det

Hvilken størrelse er mindre enn 7 16?

Skiftenøkkelstørrelser er litt lettere å finne ut enn hylsestørrelser siden du ikke har å gjøre med forskjellige skralledrivstørrelser. Størrelsestabell for skiftenøkkel for bolter. Boltdiameter Nøkkelstørrelse (Standard) Nøkkelstørrelse (metrisk) 1/8' 5/16' 8mm 3/16' 3/8' 10mm 1/4' 7/16' 11mm 5/16' 1/2' 13mm

Hvorfor er aggressiv modus mindre sikker?

Aggressiv modus er kanskje ikke like sikker som hovedmodus, men fordelen med aggressiv modus er at den er raskere enn hovedmodus (siden færre pakker utveksles). Aggressiv modus brukes vanligvis for VPN-er med ekstern tilgang. Men du vil også bruke aggressiv modus hvis en eller begge jevnaldrende har dynamiske eksterne IP-adresser