- Forfatter Lynn Donovan [email protected].

- Public 2023-12-15 23:51.

- Sist endret 2025-01-22 17:36.

Webcrawlere brukes hovedsakelig til å lage en kopi av alle de besøkte sidene for senere behandling av en søkemotor, dvs vil indekser de nedlastede sidene for å gi raske søk. Crawlere kan også brukes til å automatisere vedlikeholdsoppgaver Web nettsted, for eksempel å sjekke lenker eller validere HTML-kode.

På samme måte, hvordan fungerer en webcrawler?

EN crawler er et program som besøker Web nettsteder og leser deres sider og annen informasjon for å lage oppføringer for en søkemotorindeks. Crawlere tilsynelatende fått navnet fordi de krype gjennom en side om gangen, følg lenkene til andre sider på siden til alle sidene er lest.

hva er webcrawling og -skraping? Kryper refererer vanligvis til å håndtere store datasett der du utvikler dine egne crawlere (eller roboter) som krype til det dypeste av web sider. Data skraping på den annen side refererer til å hente informasjon fra en hvilken som helst kilde (ikke nødvendigvis web ).

Herav, hva kan du være sikker på at alle webcrawlere og hjelpeteknologi vil behandle?

Webcrawlere kopiere sider for behandling av en søkemotor som indekserer de nedlastede sidene slik at brukere kan søke mer effektivt. Crawlere kan validere hyperkoblinger og HTML-kode. De kan også brukes til web skraping (se også datadrevet programmering).

Hvilken teknologi bruker søkemotorer for å gjennomsøke nettstedsroboter?

En webcrawler, eller edderkopp, er en type bot som vanligvis drives av søkemotorer som Google og Bing. Deres formål er å indeksere innholdet i nettsteder over hele Internett slik at de nettsteder kan vises i søkemotor resultater.

Anbefalt:

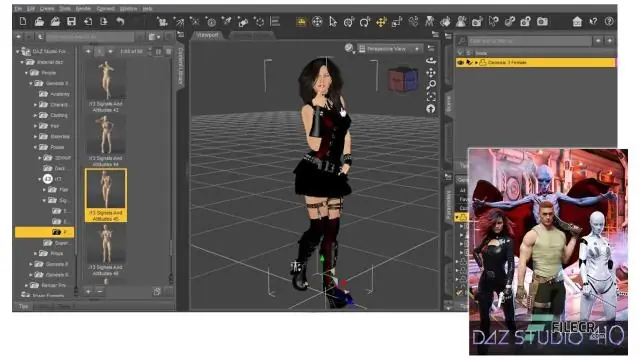

Hva kan du gjøre med DAZ Studio?

DAZ Studio er i utgangspunktet: For POSERING av figurer. Opprette animasjoner. Gjengivelse av de endelige resultatene (jpger, pngs, filmer, etc.) Rigging og vektkartleggingsfigurer. Sett sammen scenene dine

Hva kan du gjøre med gamle Raspberry Pi?

Hva skal du gjøre med din gamle Pi etter at Raspberry Pi 4 er utgitt? 1 Prøv et annet Smart Home-system. 2 Installer det på nytt som et smarthjemsystem for en venn eller et familiemedlem. 3 Gjør din gamle bringebær i en retro-spillemaskin. 4 Gjør den om til et mediasenter. 5 Gjør den om til en NAS

Hva kan jeg gjøre med en trimruter?

10 Verkstedbruk for en trimruter Trimfresen er et verktøy som kanskje ikke blir mye brukt i noen butikker, men det er unikt og overraskende allsidig verktøy. #1 - Duplisering av deler. #2 - Kutting av hengsler. #3 - Profileringskanter. #4 - Rengjøringsfiner. #5 - Trimming av hyllekant. #6 - Flush Cutting Plugs. #7 - Skjæring av snekkerarbeid

Hva kan jeg gjøre med Apache?

En webserver som Apache Http Server kan utføre mange oppgaver. Disse omfatter omskrivingsregler, virtuell hosting, mod sikkerhetskontroller, omvendt proxy, SSL-verifisering, autentisering og autorisasjon og mange flere avhengig av dine behov og ønsker

Gjøre og ikke gjøre for møterom?

Etikette for forretningsmøter: Gjør og ikke bør være punktlig. Sørg for at du kan delta på møtet i tide. Ikke introduser deg selv med ditt for- eller etternavn. Vær oppmerksom. Ikke bruk smarttelefonen. Prøv å bidra. Være trygg. Finn en komfortabel sittestilling. Ikke spis under møtet