Innholdsfortegnelse:

- Forfatter Lynn Donovan [email protected].

- Public 2023-12-15 23:51.

- Sist endret 2025-01-22 17:35.

Samle inn (Handling) - Returner alle elementene i datasettet som en matrise ved driverprogrammet. Dette er vanligvis nyttig etter et filter eller annen operasjon som returnerer en tilstrekkelig liten delmengde av dataene.

På denne måten, hva er PySpark?

PySpark Programmering. PySpark er et samarbeid mellom Apache Spark og Python. Apache Spark er et åpen kildekode-klyngedatabehandlingsrammeverk, bygget rundt hastighet, brukervennlighet og streaminganalyse, mens Python er et generellt programmeringsspråk på høyt nivå.

Dessuten, hva er kart i PySpark? Gnist Kart Transformasjon. EN kart er en transformasjonsoperasjon i Apache Spark. Den gjelder for hvert element i RDD, og den returnerer resultatet som ny RDD. Kart transformerer en RDD med lengde N til en annen RDD med lengde N. Inngangs- og utgangs-RDDene vil typisk ha samme antall poster.

På denne måten, hva er SparkContext i PySpark?

PySpark - SparkContext . Annonser. SparkContext er inngangspunktet til evt gnist funksjonalitet. Når vi kjører noen Gnist applikasjon starter et driverprogram, som har hovedfunksjonen og din SparkContext settes i gang her. Driverprogrammet kjører deretter operasjonene inne i utførerne på arbeidernoder.

Hvordan sjekker jeg PySpark-versjonen?

2 svar

- Åpne Spark shell Terminal og skriv inn kommandoen.

- sc.version Eller spark-submit --version.

- Den enkleste måten er å bare starte "spark-shell" på kommandolinjen. Den vil vise.

- gjeldende aktive versjon av Spark.

Anbefalt:

Hva er w3c hva er Whatwg?

Web Hypertext Application Technology Working Group (WHATWG) er et fellesskap av mennesker som er interessert i å utvikle HTML og relaterte teknologier. WHATWG ble grunnlagt av enkeltpersoner fra Apple Inc., Mozilla Foundation og Opera Software, ledende nettleserleverandører, i 2004

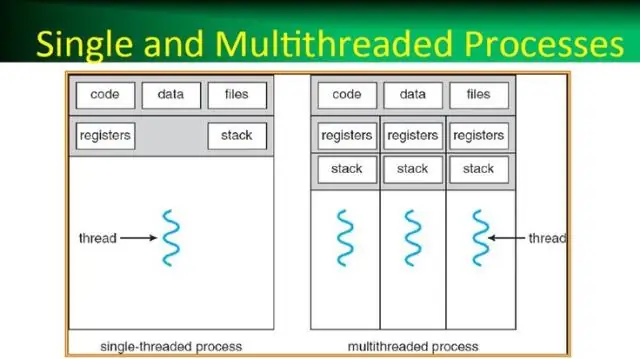

Hva er en prosess i et operativsystem hva er en tråd i et operativsystem?

En prosess, i de enkleste vilkårene, er et eksekveringsprogram. En eller flere tråder kjøres i sammenheng med prosessen. En tråd er den grunnleggende enheten som operativsystemet tildeler prosessortid til. Trådpoolen brukes først og fremst til å redusere antall applikasjonstråder og gi administrasjon av arbeidstrådene

Hva er cellereferanser og hva er de forskjellige typene referanser?

Det er to typer cellereferanser: relative og absolutte. Relative og absolutte referanser oppfører seg annerledes når de kopieres og fylles til andre celler. Relative referanser endres når en formel kopieres til en annen celle. Absolutte referanser, derimot, forblir konstante uansett hvor de kopieres

Hvordan lager jeg en PySpark DataFrame fra en liste?

Jeg følger disse trinnene for å lage en DataFrame fra listen over tuples: Lag en liste over tuples. Hver tuppel inneholder navnet på en person med alder. Lag en RDD fra listen ovenfor. Konverter hver tuppel til en rad. Lag en DataFrame ved å bruke createDataFrame på RDD ved hjelp av sqlContext

Hva er rad i PySpark?

En rad i SchemaRDD. Feltene i den kan nås som attributter. Rad kan brukes til å lage et radobjekt ved å bruke navngitte argumenter, feltene vil bli sortert etter navn