Innholdsfortegnelse:

- Forfatter Lynn Donovan [email protected].

- Public 2024-01-18 08:27.

- Sist endret 2025-01-22 17:36.

Jeg følger disse trinnene for å lage en DataFrame fra listen over tuples:

- Skape en liste av tuppel. Hver tuppel inneholder navnet på en person med alder.

- Skape en RDD fra liste ovenfor.

- Konvertere hver tuple til en rad.

- Skape en Dataramme ved å bruke createDataFrame på RDD ved hjelp av sqlContext.

Med dette i øyesyn, hvordan konverterer du en DataFrame til en liste i Python?

- Trinn 1: Konverter Dataframe til en nestet Numpy-matrise ved hjelp av DataFrame.to_numpy(), dvs.

- Trinn 2: Konverter 2D Numpy-array til en liste over lister.

- Trinn 1: Transponer datarammen for å konvertere rader som kolonner og kolonner som rader.

- Trinn 2: Konverter Dataframe til en nestet Numpy-matrise ved hjelp av DataFrame.to_numpy()

I tillegg, hva er en spark DataFrame? EN Spark DataFrame er en distribuert samling av data organisert i navngitte kolonner som gir operasjoner for å filtrere, gruppere eller beregne aggregater, og som kan brukes med Gnist SQL. Datarammer kan konstrueres fra strukturerte datafiler, eksisterende RDD-er, tabeller i Hive eller eksterne databaser.

Vet også, hva er PySpark SQL?

Spark SQL er en Gnist modul for strukturert databehandling. Den gir en programmeringsabstraksjon kalt DataFrames og kan også fungere som en distribuert SQL søkemotor. Den lar umodifiserte Hadoop Hive-spørringer kjøre opptil 100 ganger raskere på eksisterende distribusjoner og data.

Er spark DataFrames uforanderlige?

I Gnist du kan ikke - Datarammer er uforanderlig . Du bør bruke.

Anbefalt:

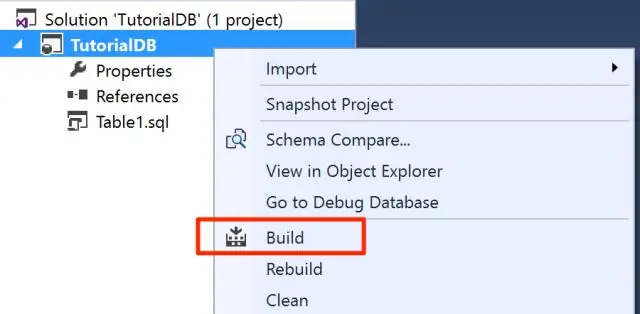

Hvordan lager jeg en SQL-database fra en BAK-fil?

Gjenopprett databasen fra en BAK-fil Navnet på gjenopprettingsdatabasen vises i listeboksen Til database. For å opprette en ny database, skriv inn navnet på den i listeboksen. Velg "Fra enhet". Klikk på knappen for å vise 'Spesifiser sikkerhetskopi'-dialogboksen. Klikk "Legg til" for å bla gjennom. bak-fil fra katalogen og klikk OK

Hvordan lager jeg en mp3 fra en DVD?

Konverter DVD-filer offline Installer og start programmet. Trykk på venstre Legg til-knapp på toppmenyen for å importere DVD-filen. Videresend til lydalternativet og velg "MP3"-format. Angi utdatamappen og klikk deretter på "Konverter"-knappen. Vent en stund og MP3-en blir lagret på PC-en

Hvordan lager jeg en stubb fra en WSDL-fil?

Generere stubfiler fra WSDL-beskrivelser I prosjektvinduet utvider du treet for et prosjekt. Høyreklikk på Kildepakker-noden og velg Ny > Annet. I kategorier-ruten velger du Annet, og i Filtyper-området velger du Mobile Webservice Client. På siden Generer J2ME Webservice Stub kan du enten:

Hvordan lager jeg en Oracle SQL-spørring fra en CSV-fil?

Trinn for å eksportere spørringsresultater til CSV i Oracle SQL Developer Trinn 1: Kjør spørringen. For det første må du kjøre spørringen i SQL Developer. Trinn 2: Åpne eksportveiviseren. Trinn 3: Velg CSV-formatet og plasseringen for å eksportere filen. Trinn 4: Eksporter søkeresultater til CSV

Hvordan lager jeg en p12-fil fra CER?

Prosessen TRINN 1: Opprett en ".certSigningRequest" (CSR)-fil. Åpne nøkkelringtilgang på Mac-en (finnes i Programmer/Verktøy) TRINN 2: Opprett ".cer"-filen i iOS-utviklerkontoen din. Logg på https://developer.apple.com. TRINN 3: Installer. cer og generere