- Forfatter Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:51.

- Sist endret 2025-06-01 05:10.

Resilient distribuerte datasett ( RDD ) er en grunnleggende datastruktur i Spark. Det er en uforanderlig distribuert samling av objekter. RDD-er kan inneholde alle typer Python, Java eller Scala objekter, inkludert brukerdefinerte klasser. Formelt sett, en RDD er en skrivebeskyttet, partisjonert samling av poster.

Spørsmålet er også, hva er forskjellen mellom RDD og DataFrame?

RDD - RDD er en distribuert samling av dataelementer spredt over mange maskiner i klynge. RDD-er er et sett med Java- eller Scala-objekter som representerer data. Dataramme - A Dataramme er en distribuert samling av data organisert i navngitte kolonner. Det er konseptuelt lik en tabell i en relasjonsdatabase.

Videre, hvordan distribueres RDD? Fleksibel Distribuert Datasett ( RDD-er ) De er en distribuert samling av objekter, som er lagret i minnet eller på disker til forskjellige maskiner i en klynge. En eneste RDD kan deles inn i flere logiske partisjoner slik at disse partisjonene kan lagres og behandles på forskjellige maskiner i en klynge.

hvordan fungerer spark RDD?

RDD-er i Gnist har en samling av poster som inneholder partisjoner. RDD-er i Gnist er delt inn i små logiske databiter - kjent som partisjoner, når en handling utføres, vil en oppgave bli lansert per partisjon. Skillevegger i RDD-er er de grunnleggende enhetene for parallellisme.

Hva er raskere RDD eller DataFrame?

RDD - Mens du utfører enkle grupperings- og aggregeringsoperasjoner RDD API er tregere. Dataramme - Ved å utføre utforskende analyser, lage aggregert statistikk om data, datarammer er raskere . RDD - Når man ønsker transformasjon og handlinger på lavt nivå, bruker vi RDD-er . Også når vi trenger abstraksjoner på høyt nivå, bruker vi RDD-er.

Anbefalt:

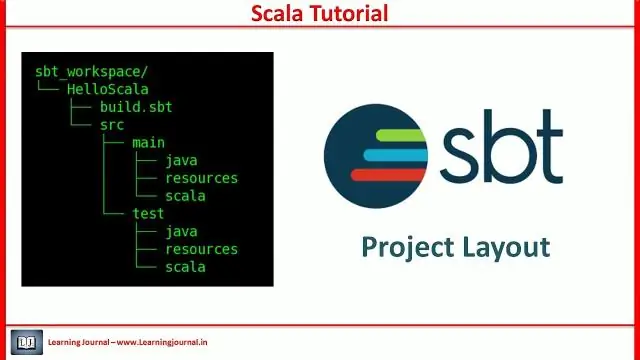

Hva er SBT-prosjektet i Scala?

Sbt er et åpen kildekode-byggeverktøy for Scala- og Java-prosjekter, som ligner på Javas Maven og Ant. Hovedfunksjonene er: Innfødt støtte for kompilering av Scala-kode og integrering med mange Scala-testrammeverk. Kontinuerlig kompilering, testing og distribusjon

Hva er skuespillere i Scala?

Scalas primære samtidighetskonstruksjon er skuespillere. Aktører er i utgangspunktet samtidige prosesser som kommuniserer ved å utveksle meldinger. Aktører kan også sees på som en form for aktive objekter der å påkalle en metode tilsvarer å sende en melding

Hva er DataFrame i spark Scala?

En Spark DataFrame er en distribuert samling av data organisert i navngitte kolonner som gir operasjoner for å filtrere, gruppere eller beregne aggregater, og som kan brukes med Spark SQL. DataFrames kan konstrueres fra strukturerte datafiler, eksisterende RDD-er, tabeller i Hive eller eksterne databaser

Hva er overstyring i Scala?

Overstyring av Scala-metoden. Når en underklasse har samme navnemetode som definert i overordnet klasse, er det kjent som metodeoverstyring. Når underklassen ønsker å gi en spesifikk implementering for metoden definert i den overordnede klassen, overstyrer den metoden fra den overordnede klassen

Hva er implisitt klasse i Scala?

Scala 2.10 introduserte en ny funksjon kalt implisitte klasser. En implisitt klasse er en klasse merket med det implisitte nøkkelordet. Dette nøkkelordet gjør klassens primære konstruktør tilgjengelig for implisitte konverteringer når klassen er innenfor omfanget. Implisitte klasser ble foreslått i SIP-13