- Forfatter Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:51.

- Sist endret 2025-01-22 17:35.

Datalokalisering i Hadoop . Ta eksempelet Wordcount, der de fleste ordene har blitt gjentatt i 5 Lacs eller flere ganger. I så fall etter Mapper-fasen vil hver Mapper-utgang ha ord i området 5 Lacs. Denne komplette prosessen med å lagre Mapper-utdata til LFS kalles som Datalokalisering.

Med tanke på dette, hva er datalokalisering i Hadoop?

Konseptet av Data lokalitet i Hadoop-data lokalitet i Kart reduksjon refererer til evnen til å flytte beregningen nær der den faktiske data ligger på noden, i stedet for å bevege seg stort data til beregning. Dette minimerer overbelastning av nettverket og øker den totale gjennomstrømningen til systemet.

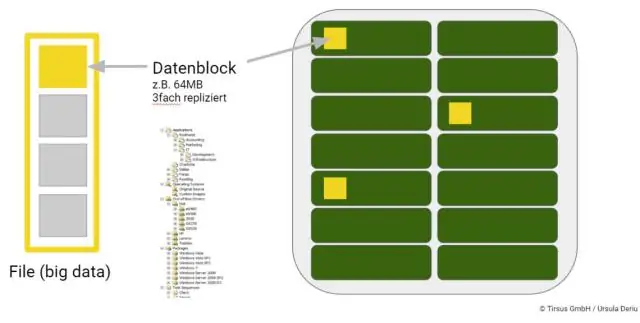

Dessuten, hvordan lagres big data? De fleste forbinder automatisk HDFS, eller Hadoop Distributed File System, med Hadoop data varehus. HDFS lagrer informasjon i klynger som består av mindre blokker. Disse blokkene er lagret i fysisk på stedet Oppbevaring enheter, for eksempel interne diskstasjoner.

Bare så, hvordan lagres data i Hadoop?

På en Hadoop klynge, den data i HDFS og MapReduce-systemet er plassert på hver maskin i klyngen. Data er lagret i data blokker på DataNodene. HDFS replikerer disse data blokker, vanligvis 128 MB i størrelse, og distribuerer dem slik at de blir replikert innenfor flere noder på tvers av klyngen.

Hvordan lagres filer i HDFS?

HDFS avslører en fil systemnavneområde og lar brukerdata være lagret i filer . Internt, a fil er delt inn i en eller flere blokker og disse blokkene er lagret i et sett med DataNoder. NameNode kjøres fil systemnavneromsoperasjoner som åpning, lukking og nytt navn filer og kataloger.

Anbefalt:

Hvordan oppnås konsensus i Blockchain?

Hva er en konsensusmekanisme? En konsensusmekanisme er en feiltolerant mekanisme som brukes i data- og blokkjedesystemer for å oppnå den nødvendige enigheten om en enkelt dataverdi eller en enkelt tilstand i nettverket blant distribuerte prosesser eller multiagentsystemer, for eksempel med kryptovaluta

Hvordan fungerer HBase i Hadoop?

HBase er en datamodell som ligner på Googles store tabell som er designet for å gi tilfeldig tilgang til store mengder strukturerte eller ustrukturerte data. HBase er en viktig komponent i Hadoop-økosystemet som utnytter feiltoleransefunksjonen til HDFS. HBase gir sanntids lese- eller skrivetilgang til data i HDFS

Hvordan oppnås multithreading i Python?

Med tråding oppnås samtidighet ved å bruke flere tråder, men på grunn av GIL kan bare én tråd kjøres om gangen. I multiprosessering er den opprinnelige prosessen forkledet til flere underordnede prosesser som omgår GIL. Hver barneprosess vil ha en kopi av hele programmets minne

Hvordan blir jeg Hadoop-administrator?

Trinn for å bli en Hadoop-administrator Forstå det grunnleggende og egenskapene til Big Data, og bruk dem til å hjelpe organisasjoner med å administrere Big Data. Arbeid med Hadoop-klienter og nettgrensesnitt. Bruk klyngeplanlegging og verktøy for dataregistrering i Hadoop-klynger. Bruk Hadoop-komponenter i Hadoop-økosystemet

Hvordan kan lat initialisering oppnås netto?

Lazy initialisering brukes først og fremst for å forbedre ytelsen, unngå sløsende beregninger og redusere krav til programminne. Ved å bruke Lazy til å erklære Orders-objektet for lat initialisering, kan du unngå å kaste bort systemressurser når objektet ikke brukes