- Forfatter Lynn Donovan [email protected].

- Public 2023-12-15 23:51.

- Sist endret 2025-01-22 17:36.

Hadoop er en åpen kildekode programvareramme som sørger for behandling av store data setter på tvers av klynger av datamaskiner ved hjelp av enkle programmeringsmodeller. Hadoop er designet for å skalere opp fra enkeltservere til tusenvis av maskiner.

Her, hva er Hadoop i dataanalyse?

Hadoop . Hadoop er et sett med åpen kildekode-programmer skrevet i Java som kan brukes til å utføre operasjoner på en stor mengde data . Hadoop er et skalerbart, distribuert og feiltolerant økosystem. Hadoop MapReduce = brukes til å laste inn data fra en database, formatere den og utføre en kvantitativ analyse på den.

hvorfor brukes Hadoop til big data-analyse? Hadoop er et åpen kildekode-programvarerammeverk for lagring data og kjører applikasjoner på klynger av råvaremaskinvare. Det gir gigantisk oppbevaring for alle slags data , enorm prosessorkraft og evnen til å håndtere praktisk talt ubegrensede samtidige oppgaver eller jobber.

Så, hva er funksjonene til Apache Hadoop i dataanalyse?

Apache Hadoop programvare er et kraftig rammeverk for å muliggjøre distribuert behandlingsformål for store datasett på tvers av flere klynger av datamaskiner. Den er designet for å skalere opp fra enkeltservere til tusenvis av servermaskiner. Dette målet anses å gi lokal beregning og lagring av hver server.

Er Hadoop en datavitenskap?

Svaret på dette spørsmålet er et stort JA! Datavitenskap er et stort felt. Hovedfunksjonen til Hadoop er oppbevaring av Big Data . Det lar også brukerne lagre alle former for data , det vil si både strukturert data og ustrukturert data . Hadoop gir også moduler som Pig og Hive for analyse i stor skala data.

Anbefalt:

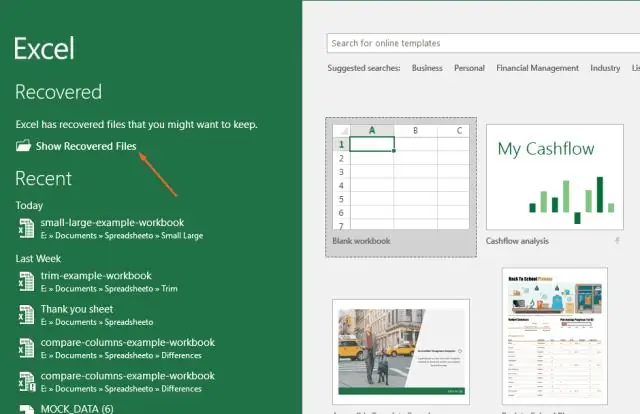

Hvordan åpner jeg dataanalyse i Excel 2007?

Excel 2007: Data Analysis-tillegget skal vises på høyre side av Data-menyen som DataAnalysis. Klikk Microsoft Office-knappen, og klikk deretter Excel-alternativer. Klikk på Tillegg, og velg deretter Excel-tillegg i Administrer-boksen. Klikk på Gå

Hvordan gjør du dataanalyse i R?

I dette innlegget vil vi gjennomgå noen funksjoner som fører oss til analysen av det første tilfellet. Trinn 1 – Første tilnærming til data. Trinn 2 – Analyse av kategoriske variabler. Trinn 3 – Analyse av numeriske variabler. Trinn 4 – Analyse av numerisk og kategorisk på samme tid

Hvordan får du dataanalyse på Excel 2011 for Mac?

I boksen Tilgjengelige tillegg merker du av for AnalysisToolPak - VBA. Merk: Analysis ToolPak er ikke tilgjengelig for Excel for Mac 2011. Last inn Analysis ToolPak i Excel Klikk Fil-fanen, klikk Alternativer, og klikk deretter Add-Inscategory. I Administrer-boksen velger du Excel-tillegg og klikker deretter på Gå

Hvordan bruker bedrifter dataanalyse i sin virksomhet?

Big data-analyse innebærer å undersøke store mengder data. Dette gjøres for å avdekke skjulte mønstre, korrelasjoner og også for å gi innsikt for å ta riktige forretningsbeslutninger. I hovedsak ønsker bedrifter å være mer objektive og datadrevne, og derfor omfavner de kraften til data og teknologi

Hvordan brukes dataanalyse i idrett?

Det er to nøkkelaspekter ved sportsanalyse - analyse på og utenfor banen. Analyse på banen handler om å forbedre ytelsen på banen til lag og spillere. Off-field analytics bruker i hovedsak data for å hjelpe rettighetshavere med å ta beslutninger som vil føre til høyere vekst og økt lønnsomhet