- Forfatter Lynn Donovan [email protected].

- Public 2023-12-15 23:51.

- Sist endret 2025-01-22 17:35.

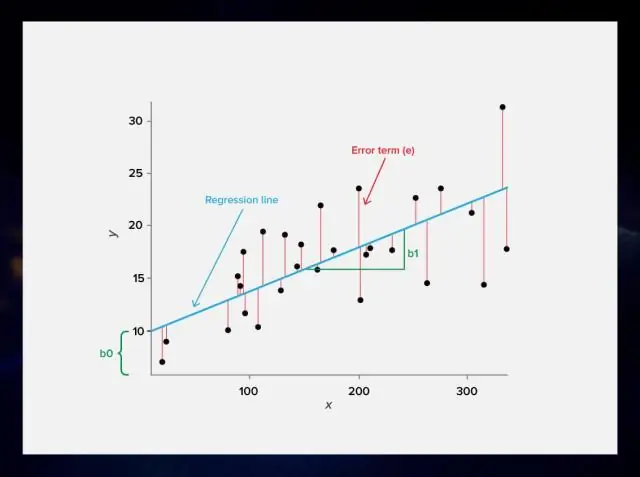

Regulering . Dette er en form for regresjon , som begrenser/regulariserer eller krymper koeffisientestimatene mot null. Med andre ord, fraråder denne teknikken å lære en mer kompleks eller fleksibel modell , for å unngå risiko for overmontering. Et enkelt forhold for lineær regresjon ser slik ut.

Tilsvarende, hva er lambda i lineær regresjon?

Når vi har høy grad lineær polynom som brukes til å passe et sett med punkter i en lineær regresjon oppsett, for å forhindre overtilpasning, bruker vi regularisering, og vi inkluderer en lambda parameter i kostnadsfunksjonen. Dette lambda brukes deretter til å oppdatere theta-parametrene i gradient-nedstigningsalgoritmen.

For det andre, hva er hensikten med regularisering? Regulering er en teknikk som brukes for å stille inn funksjon ved å legge til en ekstra strafferamme i feilen funksjon . Tilleggsbegrepet styrer det overdrevent fluktuerende funksjon slik at koeffisientene ikke tar ekstreme verdier.

På denne måten, hvorfor trenger vi å regularisere i regresjon?

Målet med regularisering er å unngå overfitting, med andre ord vi prøver å unngå modeller som passer ekstremt godt til treningsdataene (data som brukes til å bygge modellen), men som passer dårlig til testdata (data som brukes til å teste hvor god modellen er). Dette er kjent som overfitting.

Hva betyr regularisering?

I matematikk, statistikk og informatikk, spesielt innen maskinlæring og omvendte problemer, regularisering er prosessen med å legge til informasjon for å løse et uheldig problem eller for å forhindre overmontering. Regulering gjelder objektive funksjoner i dårlig stilte optimaliseringsproblemer.

Anbefalt:

Hva er nn lineær i PyTorch?

Fra dokumentasjon: CLASS torch.nn.Linear(in_features, out_features, bias=True) Bruker en lineær transformasjon på innkommende data: y = xW^T + b. Parametere: in_features – størrelsen på hver inndataprøve

Hva er lineær og ikke-lineær i datastruktur?

1. I en lineær datastruktur er dataelementer ordnet i en lineær rekkefølge hvor hvert element er festet til dets forrige og neste tilstøtende. I en ikke-lineær datastruktur er dataelementer festet på hierarkisk måte. I lineær datastruktur kan dataelementer bare krysses i en enkelt kjøring

Hva er definisjonen på en lineær blokkkode?

'En lineær blokkkode er en blokkkode der den eksklusive eller av to kodeord resulterer i et annet kodeord

Hva er ML-regresjon?

Regresjon er en ML-algoritme som kan trenes til å forutsi reelle nummererte utganger; som temperatur, aksjekurs osv. Regresjon er basert på en hypotese som kan være lineær, kvadratisk, polynomisk, ikke-lineær osv. Hypotesen er en funksjon som er basert på noen skjulte parametere og inngangsverdiene

Hva er lineær blokkkode?

I kodingsteori er en lineær kode en feilkorrigerende kode som enhver lineær kombinasjon av kodeord også er et kodeord for. Kodeordene i en lineær blokkkode er blokker med symboler som er kodet med flere symboler enn den opprinnelige verdien som skal sendes