- Forfatter Lynn Donovan [email protected].

- Public 2023-12-15 23:51.

- Sist endret 2025-01-22 17:35.

Datainntak er prosessen med å skaffe og importere data for umiddelbar bruk eller lagring i en database. Å innta noe er å «ta noe inn eller absorbere noe». Data kan streames i sanntid eller inntatt i partier.

Vet også, hva er datainntakspipeline?

Datainntaksrørledning . EN pipeline for datainntak flytter strømming data og batch data fra eksisterende databaser og data varehus til en data innsjø. For en HDFS-basert data lake, brukes verktøy som Kafka, Hive eller Spark til datainntak . Kafka er en populær datainntak verktøy som støtter streaming data.

Videre, hvordan inntar Hadoop data? Hadoop bruker et distribuert filsystem som er optimert for lesing og skriving av store filer. Når du skriver til HDFS , data "skjæres" og replikeres på tvers av serverne i en Hadoop klynge. Skjæringsprosessen lager mange små underenheter (blokker) av den større filen og skriver dem transparent til klyngenodene.

For det andre, hva er datainntaksverktøy?

Verktøy for datainntak gi et rammeverk som lar bedrifter samle inn, importere, laste, overføre, integrere og behandle data fra et bredt spekter av data kilder. De legger til rette for data utvinningsprosessen ved å støtte ulike data transportprotokoller.

Hva er din forståelse av datainntak og integrering?

Datainntak er de Prosess av inntak av data fra ett system til et annet. Dataintegrasjon tillater forskjellige data typer (som f.eks data sett, dokumenter og tabeller) som skal slås sammen og brukes av applikasjoner for personlige eller forretningsprosesser.

Anbefalt:

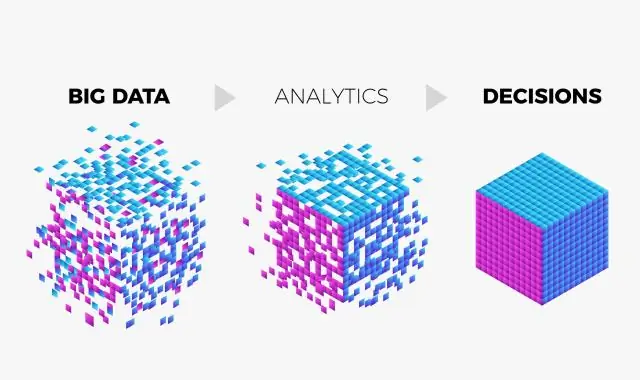

Hva er rollen til big data analytiker?

Big data-analytikere er ansvarlige for å bruke dataanalyse og CRM for å evaluere en organisasjons tekniske ytelse og gi anbefalinger om systemforbedringer. Disse analytikerne kan fokusere på problemer som streaming og live data og datamigrering

Hva gjør Google med big data?

Svaret er Big data-analyse. Google bruker Big Data-verktøy og -teknikker for å forstå kravene våre basert på flere parametere som søkehistorikk, steder, trender osv

Hva er Impala i big data?

Impala er en spørremotor for massiv parallellbehandling med åpen kildekode på toppen av grupperte systemer som Apache Hadoop. Den ble laget basert på Googles Dremel-papir. Det er en interaktiv SQL-lignende spørringsmotor som kjører på toppen av Hadoop Distributed File System (HDFS). Impala bruker HDFS som sin underliggende lagring

Hva er V-ene til big data?

I de fleste store datakretser kalles disse de fire V-ene: volum, variasjon, hastighet og sannhet. (Du kan vurdere en femte V-verdi.)

Hva er use case i big data?

Selv om de fleste tilfeller av big data-bruk handler om datalagring og -behandling, dekker de flere forretningsaspekter, for eksempel kundeanalyse, risikovurdering og svindeloppdagelse. Så hver bedrift kan finne den relevante brukssaken for å tilfredsstille deres spesielle behov