Innholdsfortegnelse:

- Forfatter Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:51.

- Sist endret 2025-01-22 17:35.

Konfigurasjonsfilene som må oppdateres for å sette opp en fullt distribuert modus for Hadoop er:

- Hadoop-env.sh.

- Kjerne-side. xml.

- Hdfs-side. xml.

- Kartlagt nettsted. xml.

- Mestere.

- Slaver.

Dessuten, hva er de viktige konfigurasjonsfilene i Hadoop?

Hadoop-konfigurasjon er drevet av to typer viktige konfigurasjonsfiler:

- Skrivebeskyttet standardkonfigurasjon - src/core/core-default. xml, src/hdfs/hdfs-default. xml og src/mapred/mapred-default. xml.

- Nettstedsspesifikk konfigurasjon - conf/core-site. xml, conf/hdfs-side. xml og conf/mapred-site. xml.

På samme måte, hvilke av følgende inneholder konfigurasjon for HDFS-demoner? xml inneholder konfigurasjon innstillinger av HDFS-demoner (dvs. NameNode, DataNode, Secondary NameNode). Det inkluderer også replikeringsfaktoren og blokkstørrelsen til HDFS.

hva er konfigurasjonsfiler i Hadoop?

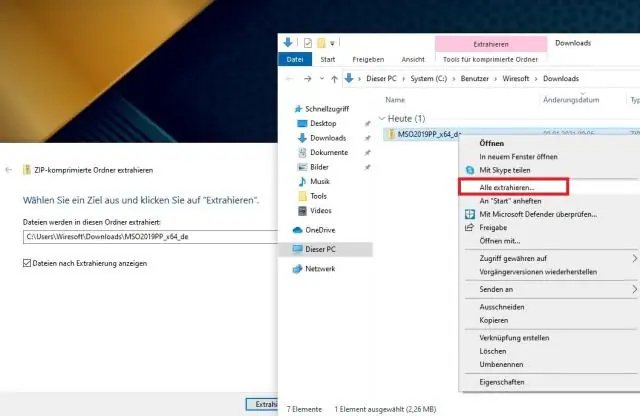

Konfigurasjonsfiler er filer som befinner seg i den utvunnede tjæren. gz fil i etc/ hadoop / katalog. Alle Konfigurasjonsfiler i Hadoop er oppført nedenfor, 1) HADOOP -ENV.sh->>Det spesifiserer miljøvariablene som påvirker JDK som brukes av Hadoop Daemon (bin/ hadoop ).

Hvilke filer håndterer små filproblemer i Hadoop?

1) HAR ( Hadoop Arkiv) Filer har blitt introdusert til håndtere små filer problem . HAR har introdusert et lag på toppen av HDFS , som gir grensesnitt for fil tilgang. Ved hjelp av Hadoop arkivkommando, HAR filer er opprettet, som kjører en Kart reduksjon jobb med å pakke filer blir arkivert i mindre antall HDFS-filer.

Anbefalt:

Kan du sette opp en faksmaskin uten fasttelefon?

Ja, du kan ha et faksnummer uten en fasttelefonlinje. For å ha et faksnummer og bruke afaksmaskin (eller datamaskin med faksprogramvare) trenger du en fasttelefonlinje. VoIP-telefonlinjer vil ikke fungere. En mobiltelefon kan fakse ved hjelp av en nettfakstjeneste

Bør jeg sette opp orkan skodder?

National Hurricane Center-talsmann Dennis Feltgen anbefaler å sette opp orkanskodder når en orkanklokke blir utstedt for ditt område. Et orkanvarsel er når tropiske stormforhold forventes om 36 timer. Det anbefales at forberedelsene fullføres før utbruddet av tropiske stormvinder

Hva er det totale antallet kommunikasjonslinjer som trengs for et fullt tilkoblet punkt-til-punkt-nettverk med fem datamaskiner og seks datamaskiner?

Antallet kommunikasjonslinjer som kreves for et fullt tilkoblet punkt-til-punkt-nettverk med åtte datamaskiner er tjueåtte. Et fullstendig tilkoblet ni datanettverk krever trettiseks linjer. Et fullstendig tilkoblet ti datanettverk krever førtifem linjer

Trenger jeg en Ethernet-kabel for å sette opp en trådløs ruter?

Først må du koble ruteren til modemet. For dette trenger du en Ethernet-kabel, som du vil koble til WAN-porten (wide-areanetwork) på ruterens bakside

Hvilken kommando bruker du for å sette opp et Git-lager inne i mappen din?

Start et nytt git-lager Opprett en katalog for å inneholde prosjektet. Gå inn i den nye katalogen. Skriv git init. Skriv litt kode. Skriv git add for å legge til filene (se siden med vanlig bruk). Skriv git commit